ทีมงาน BT ได้มีโอกาสอัปเดตเรื่อง SEO ล่าสุดจาก Google ในงาน Search Central Live Bangkok เมื่อวันที่ 9 สิงหาคม 2024 ที่คนทำเว็บทุกคนควรรู้ จึงสรุปมาให้อ่านกัน

เว็บที่กูเกิ้ลชอบ

- สร้างเนื้อหาโดยโฟกัสกับมนุษย์

- เนื้อหาในเว็บแสดงถึงความเชี่ยวชาญ มีความน่าเชื่อถือ

- เนื้อหาและคุณภาพเว็บ เนื้อหาที่เขียนเป็นออริจินัล หรือมีคุณค่ามากกว่าเว็บในกลุ่มเดียวกันไหม

- การนำเสนอและโปรดักชัน เช่น ไม่มีโฆษณาในเว็บมารบกวน, หรือเนื้อหาทำมาเพื่อเว็บเดียว ไม่ใช่ทำเนื้อหาเดียวแล้วไปลงหลาย ๆ ที่

- สรุปคือพยายามหลีกเลี่ยงเนื้อหาที่สร้างเพื่อ Google โดยเฉพาะ ให้เน้นสร้างเนื้อหาเพื่อมนุษย์

ช่วงแก้ความเข้าใจผิด

- – Google ชอบ subdomain (เช่น buzz.bt.th) มากกว่า sub-directory (เช่น bt.th/buzz) จริงไหม

- ตอบ: ไม่ได้ชอบแบบไหนเป็นพิเศษ ทำแบบไหนก็ได้ที่เหมาะสม

- ซื้อ backlink ในเว็บอื่น ๆ ไม่ได้ทำให้อันดับใน Google ดีขึ้น อย่างเว็บ Porsche ของนอร์เวย์ ไม่มีลิงก์เลย แต่ก็ได้อันดับดีมาก

- ลิงก์คุณภาพต่ำยิงเข้ามาเว็บเรา ไม่เกี่ยวกับอันดับของเราเลย อย่ากังวล

- เนื้อหาจาก AI ก็อาจจะได้อันดับดีใน google ได้ ขึ้นอยู่กับคุณภาพของงาน

- Google ไม่มีข้อจำกัดเรื่องความยาวเนื้อหา ว่าเขียนยาวไปอันดับจะตก ดูที่คุณภาพเป็นหลัก

- อีกเรื่องที่ไม่จริงคือ ซื้อโดเมนเก่าที่มีอายุแล้วหมดอายุแล้ว จะได้ Rank ที่ดี คือเมื่อโดเมนหมดอายุ Google จะพยายามลบ Signal เดิมออก เพราะงั้นก็จะเหมือนโดเมนใหม่ Page Rank ใหม่

- โดเมนใหม่ก็สามารถแข่งอันดับกับโดเมนเก่าได้เหมือนกัน เช่น ทำรูปให้ดี ไปติดอันดับในการค้นหารูป ได้ยอดเข้าเว็บเยอะ ก็ทำได้เหมือนกัน

- Schema ไม่มีผลต่อ Rank แต่มีผลกับพื้นที่ในหน้าค้นหาที่อาจจะใหญ่ขึ้น

- เปรียบเทียบความสำเร็จหลังปรับเว็บ ให้ดูข้อมูลเป็นรายสัปดาห์ เทียบกับสัปดาห์ก่อนหน้านั้น แล้วก็เทียบกับช่วงเดียวกันของเดือนที่แล้ว แล้วดูว่า keyword เปลี่ยนแปลงไปไหม

- Google ไม่ได้ให้ความสำคัญกับชื่อ URL เท่าเมื่อก่อนแล้ว เพราะตอนนี้สามารถวิเคราะห์เนื้อหาในหน้าได้แล้ว เพราะฉะนั้นจะตั้ง URL เป็นภาษาไทยหรืออังกฤษก็ได้

- ทำยังไงให้ติด SGE (Google Search Generative Experience) ตอบ ตอนนี้ยังไม่มีเอกสารอย่างเป็นทางการออกมา แต่ให้คิดเหมือน Snippet หรือข้อมูลแนะนำที่ Google แสดงเวลาค้นหา ถ้าติดใน Snippet ได้ SGE ก็คล้าย ๆ กัน

- เรื่องคุณภาพของเนื้อหาที่สร้างด้วย AI ก็เป็นประเด็นที่ Google ให้ความสำคัญ เราอาจไม่รู้ว่าเนื้อหาที่ดูโครงสร้างดีนี้สร้างด้วย AI แล้วข้อมูลมันผิด เราเลยให้ความสำคัญกับการจัดเว็บที่อยู่ในหมวดข่าวมาก เพราะชื่อของเว็บจะเป็นตัวการันตีเนื้อหาได้

- ตอนนี้ Google Crawer ดึงเนื้อหาในรูปแบบมือถือ การกำหนดเว็บให้แสดงบนมือถือให้ถูกต้องจึงเป็นเรื่องสำคัญ

- Google มองความเชี่ยวชาญของเว็บเป็นน้ำหนักในการให้อันดับเว็บ เช่น เป็นเว็บข่าว แล้วไปทำอย่างอื่นที่อาจจะไม่เกี่ยว ก็อาจถูกลดน้ำหนัก สิ่งที่ต้องคิดคือทำให้คนรู้ว่าเป็นเนื้อหาแยกกัน Google ไม่ได้ตอบว่าในทางเทคนิคจะเป็นการแยกด้วย Sub domain หรือ Sub Directory หรือยังไง แต่ให้คิดจากความรู้สึกของผู้ใช้ว่าเข้าใจไหมว่าเป็นเนื้อหาแยกกัน

ตำรา SEO ภาษาไทยจากกูเกิ้ล ดีมาก ทุกคนควรอ่าน developers.google.com/search/docs?hl=th

เรื่อง Index หน้าเว็บ

- การทำงานของการค้นหาของ Google มี 3 กระบวนการคือ

- 1. Crawling

- 2. Indexing

- 3. Serving

- เมื่อ Google รู้ว่ามีเว็บอะไร ก็จะตามลิงก์ไปเก็บเรื่อย ๆ

- Crawler คือ Googlebot ซึ่งจะตัดสินใจด้วยตัวเองว่าควรจะดึงข้อมูลบ่อย ดึงเยอะแค่ไหน ความเร็วของเว็บก็มีส่วน คุณภาพเนื้อหาก็มีส่วน ถ้าเซิร์ฟเวอร์มีปัญหาก็จะเข้าน้อยลง

- แต่การเข้ามาตรวจบ่อย ไม่ได้แปลว่าอันดับใน Google จะสูงขึ้น

- ถ้าใครไม่อยากให้เนื้อหาหลุดไป ก็ใช้ robot.txt เพื่อป้องกันบอต Google มาส่องได้

- index ของ Google ใหญ่มาก ใหญ่แบบพิมพ์แล้วไปกลับดวงจันทร์ได้ 12 รอบ

- มี keyword แค่ไหนถึงจะดี -> การมี keyword ในหน้าเยอะแล้วดีเป็นความรู้เก่า เอาที่ใช้ปกติ คนอ่านแล้วไม่หงุดหงิด

- Meta Keyword สำคัญไหม -> Google ไม่เคยใช้ Meta Keyword

- Google เข้าใจรูปภาพแบบทั่ว ๆ ไป คือ AI พิจารณาองค์ประกอบภาพเองได้ เช่น ภาพผู้ชายหน้าบ้าน แต่ถ้าจะเจาะจงกว่านั้น เช่น ผู้ชายชื่ออะไร ก็ต้องใส่คำบรรยายรูป หรือใส่ Alt Attribute เพื่อบอกว่ารูปอะไร

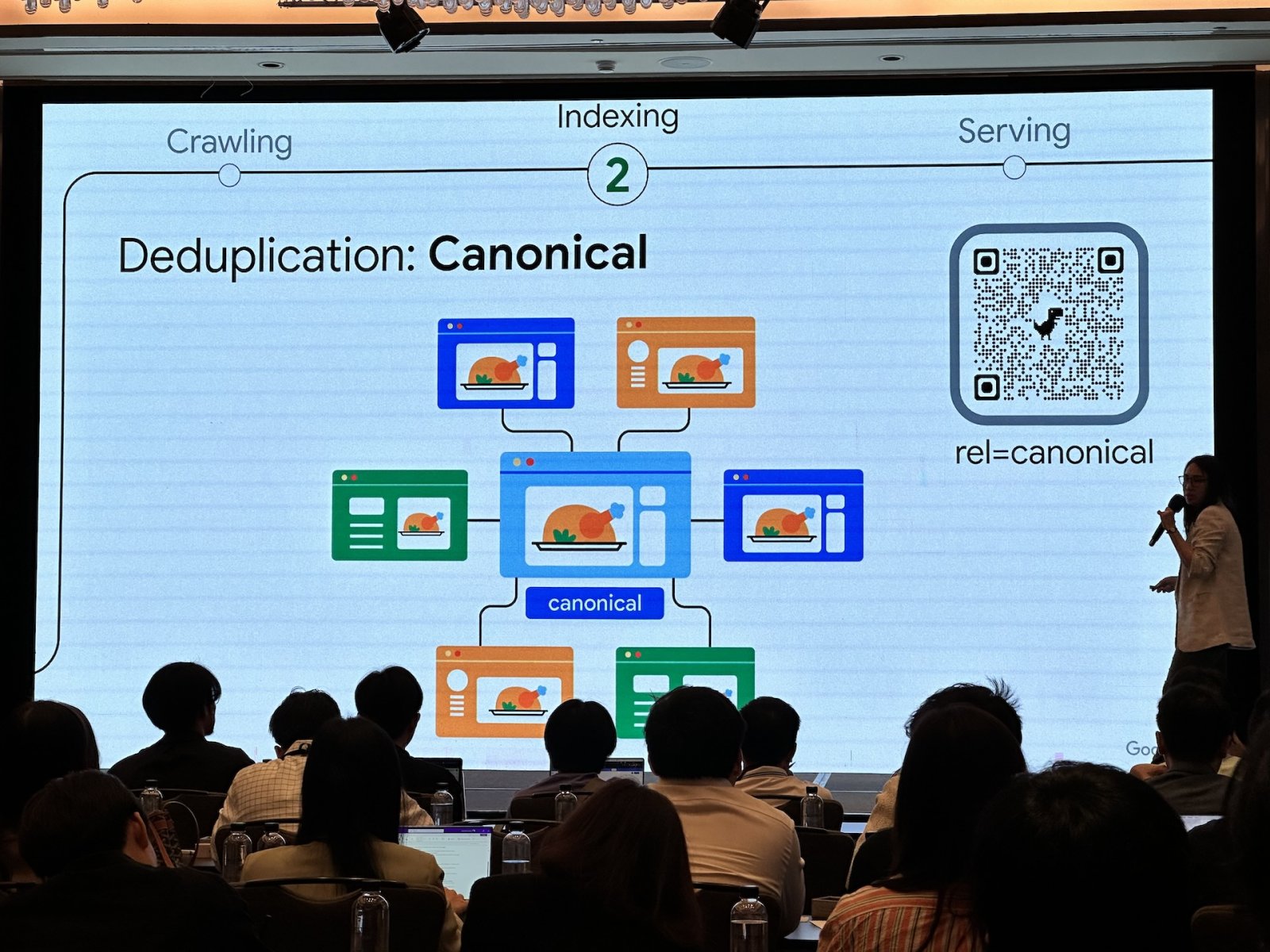

- หลังจาก Crawling แล้วก็จะมาจัดกลุ่ม URL ที่ไปหน้าที่มีเนื้อหาซ้ำ Canonical คือตัวแทนกลุ่ม สำหรับหน้าซ้ำ แล้วเก็บเป็นกลุ่ม

- หลังจากเก็บข้อมูลแล้วจะเข้าสู่ Index Selection เพื่อดูว่าควรอยู่ใน Index เพื่อให้ค้นเจอไหม อย่างหน้าที่จัดเป็น Canonical จะไม่ถูกค้นเจอ เจอแค่หน้าต้นฉบับ

- แล้วถ้าเจอ Discovered – not indexed (คือเจอหน้าแล้ว แต่ Google ไม่ได้ index ไว้) ใน Search Console แล้วจะทำยังไงได้บ้าง ส่วนใหญ่เป็นปัญหาเรื่องคุณภาพหน้า คือหน้านั้นไม่มีคุณภาพดีพอที่จะเก็บหรือนำเสนอผู้ใช้ ก็ต้องแก้ปัญหาคุณภาพหน้า

- หลังจาก Index แล้วคือ Serving หรือการส่งข้อมูลให้ผู้ใช้ค้นหา

- ถ้าเป็นภาษาไทยจะแบ่งส่วนคำ เพราะคำไทยไม่มีการเว้นวรรค ส่วนถ้าเป็นภาษาอังกฤษจะตัดคำ stopword ออก เช่น of, the แต่ถ้าเป็นคำเฉพาะเช่น the lord of the ring จะเข้าใจว่าเป็นคำเฉพาะ ไม่ได้ตัด

- มาถึงตรงนี้ Google ย้ำมากเรื่องคุณภาพของเนื้อหา หลายรอบ

คุณภาพของเนื้อหา

- สิ่งที่ขัดใจผู้ใช้ที่สุดคือ Spam กูเกิ้ลคือพยายามตัดเรื่องนี้ออกจากผลการค้นหา

- Cloaking คือซ่อนเนื้อหาสแปมไว้

- Doorways ทำเนื้อหาที่หลากหลาย เพื่อกลบเนื้อหาสแปม

- Scraped content ไปดูดเนื้อหาเว็บอื่นมา ซึ่งนับเป็นสแปมเพราะไม่ได้สร้างเนื้อหาใหม่

- Link SPAM ตรงตัว คือลิงก์หาสแปม

- Hacked Content คือโดนแฮก ซึ่งถ้าเจอ Google ก็จะตัดออกจาก index

Core Update มาทีไรเสียวทุกที

- Google โฟกัสเรื่อง Helpfulness หรือความเป็นประโยชน์กับคน ให้น้ำหนักกับเรื่องนี้ในการจัด Ranking เว็บ จึงเป็น Core Update ที่มาให้คนทำเว็บตื่นเต้นกันอยู่ตลอด

- เพราะ Google พยายามพัฒนาระบบตรวจสอบคุณภาพเนื้อหาให้ดีขึ้นเรื่อย ๆ โดยไม่มีใครได้สิทธิ์พิเศษในผลค้นหา

- เมื่อปรับแล้วก็จะมานั่งรีวิวว่าคุณภาพเป็นยังไง (Search Quality Rater Guidelines)

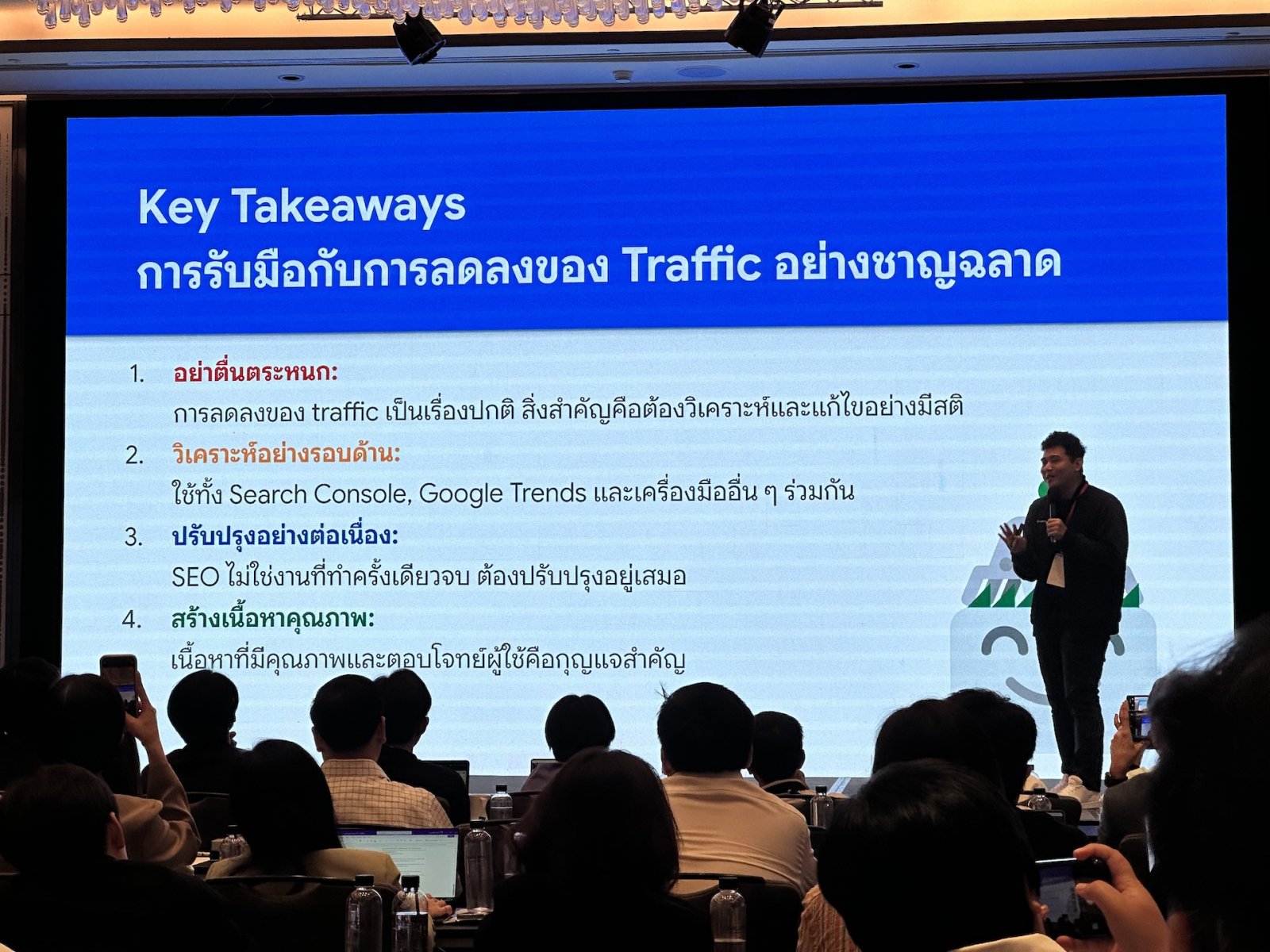

ถ้า Google อัปเดตแล้ว อันดับแย่ลงทำยังไง

- ต้องดูก่อนว่าเราโดนอัปเดตรอบไหนไปทำให้อันดับตกลง

- รอบ Spam update การปรับการตรวจสแปม ถ้าโดนจัดเป็นสแปมในการอัปเดตใหม่ อันดับก็ต่ำลง

- รอบ Core update อัปเดตการตรวจคุณภาพเนื้อหา อัปเรื่อย ๆ โดยไม่โฟกัสที่เว็บไหนเป็นหลัก

- ใช้ส่วนเสริม GSC-guardian ใน Chrome ช่วยตีกรอบใน Google Search Console ได้ว่าช่วงไหนของกราฟ สอดคล้องกับการอัปเดตการค้นหาอะไรได้บ้าง

- สรุปคือ ถ้าอันดับลด ลองค้นคำที่เคยได้ดี แล้วดูเว็บที่อันดับกลายเป็นสูงกว่าเรา ดูว่าเค้าทำยังไง (Google ยอมบอกแค่นี้)

การใช้ Google Trends สำหรับ SEO

- เวลาค้นให้เลือก Term ให้ถูกด้วย เช่น Alphabet เป็นบริษัทหรือตัวอักษร

- ถ้าค้นคำใน Google Trends แล้วไม่มีกราฟขึ้น กราฟตกเป็นศูนย์ ก็อย่าใช้คำนี้ คนสนใจน้อย

- การควบคุมการค้นหาใน Google Trends คือ” ” ใช้เพื่อเจาะจงคำ, – ใช้ลบคำออก, + คือ OR

- Google Trends สามารถค้น keyword เทียบกับเวลาในอดีตได้ โดยใส่ filter ปีลงไป ใส่เป็นประเทศก็ได้ จะได้หาแนวโน้มได้ว่าช่วงนี้ของแต่ละปี keyword นี้จะกลับมาไหม

- นอกจากนี้ยังสามารถเปลี่ยนจาก Web Search เป็น YouTube search เพื่อดูเทรนด์ค้นหาของ YouTube ใน Trends ก็ได้

ฟีเจอร์ของ Google Search

- Knowledge Panel (เช่น กล่องเวลาค้นหาที่บอกว่าคนที่เราค้นหาเป็นใคร) ถ้าเป็นเจ้าของเรื่องนั้นจริง ๆ ก็ใช้บัญชีส่วนตัวอ้างสิทธิ์และแก้ไขข้อมูลได้

- ถ้าเป็นธุรกิจก็ใช้ Google Business Profile เพิ่มพวกสถานที่ให้ค้นเจอใน Google Maps และใส่เว็บหรือข้อมูลอื่น ๆ ได้ ซึ่งถ้าข้อมูลครบถ้วนจะได้ความน่าเชื่อถือมากจากผู้ใช้

- Structured Data ทำให้ Google เข้าใจเนื้อหามากขึ้น เช่น Product Snippet ถ้าทำ Structured Data ลงเว็บ Google จะนำไปแสดงในผลการค้นหาได้สวยขึ้น ดูเด่นขึ้น

- อย่าง Structured Data แบบ NewsArticle ทำให้ Google เข้าใจว่าเป็นข่าวมากขึ้น

- Search Console สามารถดูเรื่อง Rich snippet ได้แล้ว ปรับเว็บแล้ว Google ดูดข้อมูล Rich snippet ไหม ก็ดูได้

Google กับวิดีโอ

- Google กำลังต้องการวิดีโอคุณภาพสูง และตรงกับความต้องการของผู้ใช้

- สามารถใช้ตัวแปร Site: เพื่อเจาะเฉพาะเว็บเรา และดูที่แท็บ Video ใน Google เพื่อดูว่า index วิดีโอไปเท่าไหร่

- ฟีเจอร์ใหม่คือต่อไปจะสามารถค้นหาเฉพาะจุด ๆ หนึ่งในวิดีโอได้แล้ว

- Google ชอบเพจที่เป็นวิดีโอโดยเฉพาะ ไม่ต้องรวมเนื้อหาหลาย ๆ อย่างในหน้าวิดีโอ หน้าวิดีโอคือมีแต่วิดีโอที่เด่น แล้วก็ประกอบเนื้อหาของวิดีโอนั้นก็พอ

- แล้วถ้าเป็นวิดีโอจากเพจที่เสียเงิน ก็สามารถเขียนข้อมูลให้ Google เข้าถึงวิดีโอได้ เพื่อเอาไปทำดัชนี คนจะได้หาเจอ แล้วพอกดเข้ามาจะเจอหน้าเก็บเงินของเว็บก็ได้

- ใน Search Console มีรายงาน Video Indexing ให้ดูด้วย

เว็บที่มีหลายภาษา

- หน้าเว็บต่างภาษา Google แนะนำควรจะใช้ URL ที่ต่างกันไปเลย

- ใช้ฟังก์ชัน hreflang ในโค้ดเว็บ เพื่อบอก Google ว่าเป็นหน้าเดียวกัน แต่ต่างภาษา และต้องติดในทุกหน้าที่ต่างภาษากัน เพื่อยืนยันว่าเราเป็นเจ้าของทั้งหมด

- หรือใส่ใน sitemaps ก็ได้ เหลือทางใดทางหนึ่ง

- Google จะตัดสินใจให้หน้านั้นเป็นภาษาใดภาษาหนึ่งเท่านั้น Google ไม่มีการบอกว่าหน้านั้นเป็น 2 ภาษา เพราะงั้นควรแยกหน้ากัน ไม่ควรรวมหลายภาษาในหน้าเดียว

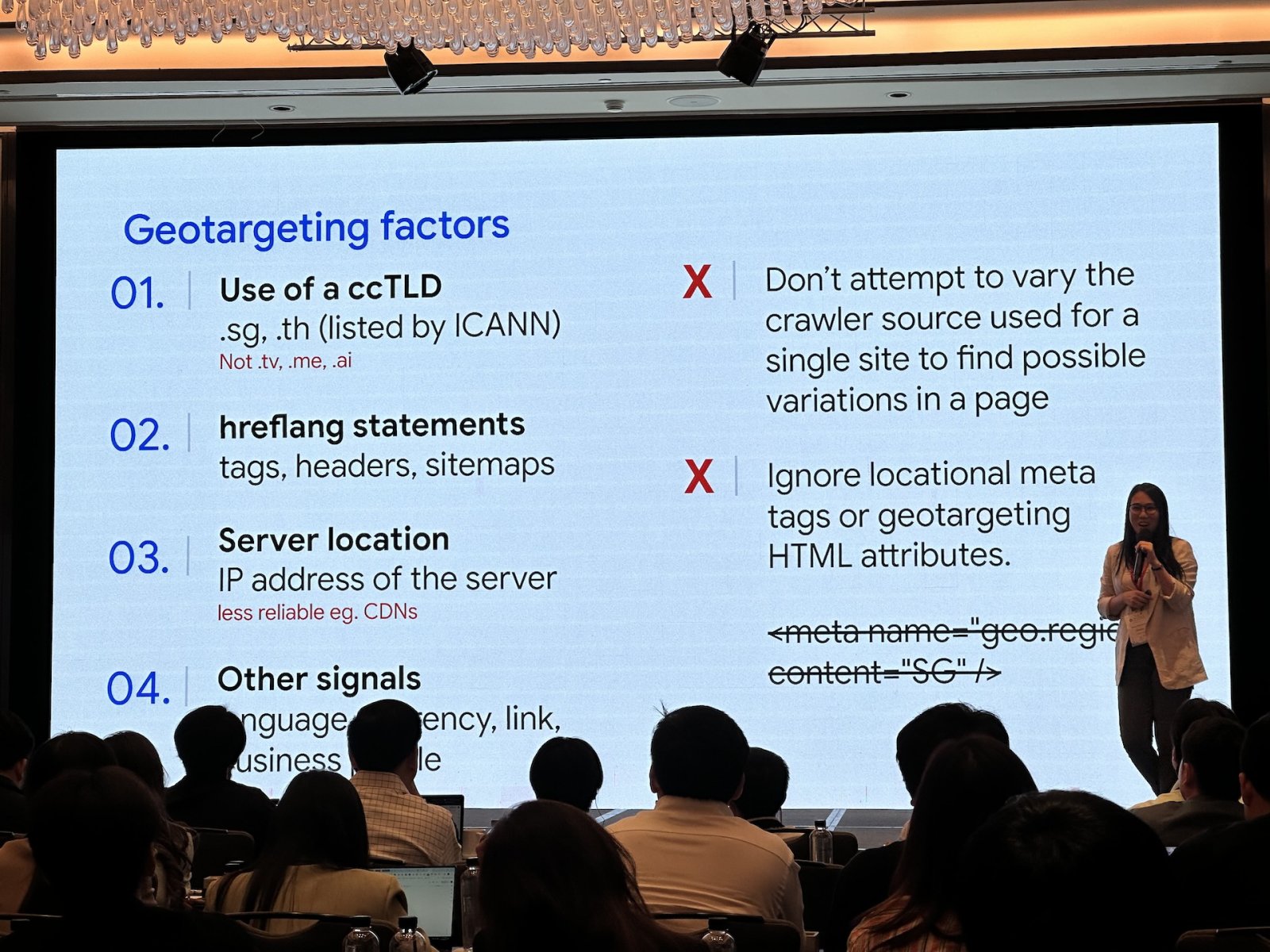

เว็บที่ Target เฉพาะประเทศ

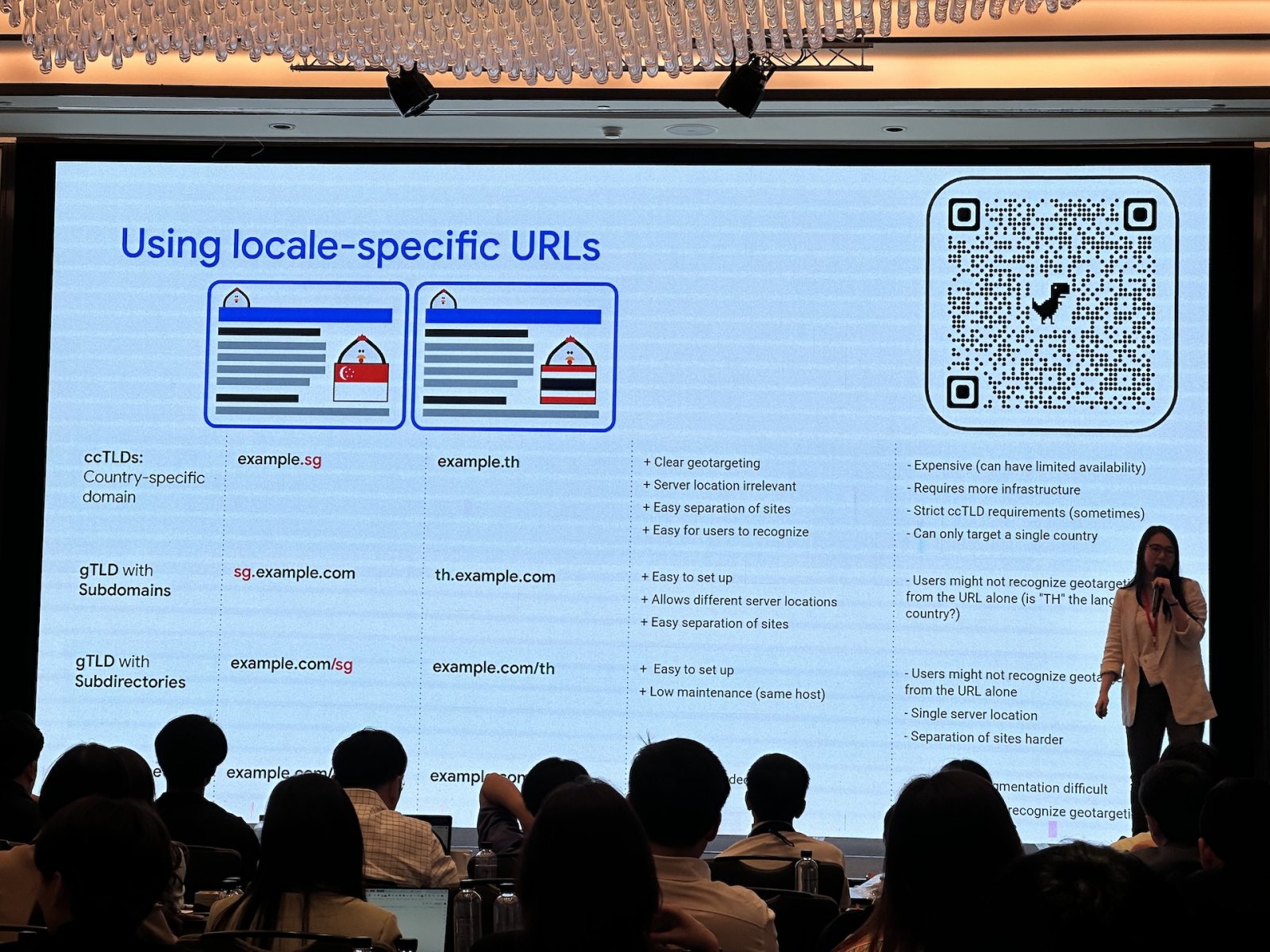

- คิดจาก ccTLD (Country Code Top-level Domain) เช่น .th .jp เป็นหลัก แล้วก็ข้อมูล hreflang เป็นตัวรอง

- ซึ่ง Bot ของ Google ไม่ได้ทดลองเป็นชาติต่าง ๆ เวลาเข้าไป เช่น ถ้าบล็อกทราฟฟิกจากอเมริกา Bot อาจจะเข้าไม่ได้

- เพราะฉะนั้นการซื้อ ccTLD สำหรับเว็บในประเทศต่าง ๆ จะเป็นสิ่งที่ Google ตรวจง่ายที่สุด แต่ถ้าทำไม่ได้ ก็ต้องเปลี่ยนไปทาง SubDomain หรือ SubDirectory แทน

- Google เข้าใจโดเมนภาษาไทย

- แต่ Google ไม่เข้าใจภาษาคาราโอเกะ เพราะไม่มีมาตรฐาน และคนใช้น้อย

ว่าด้วย AI

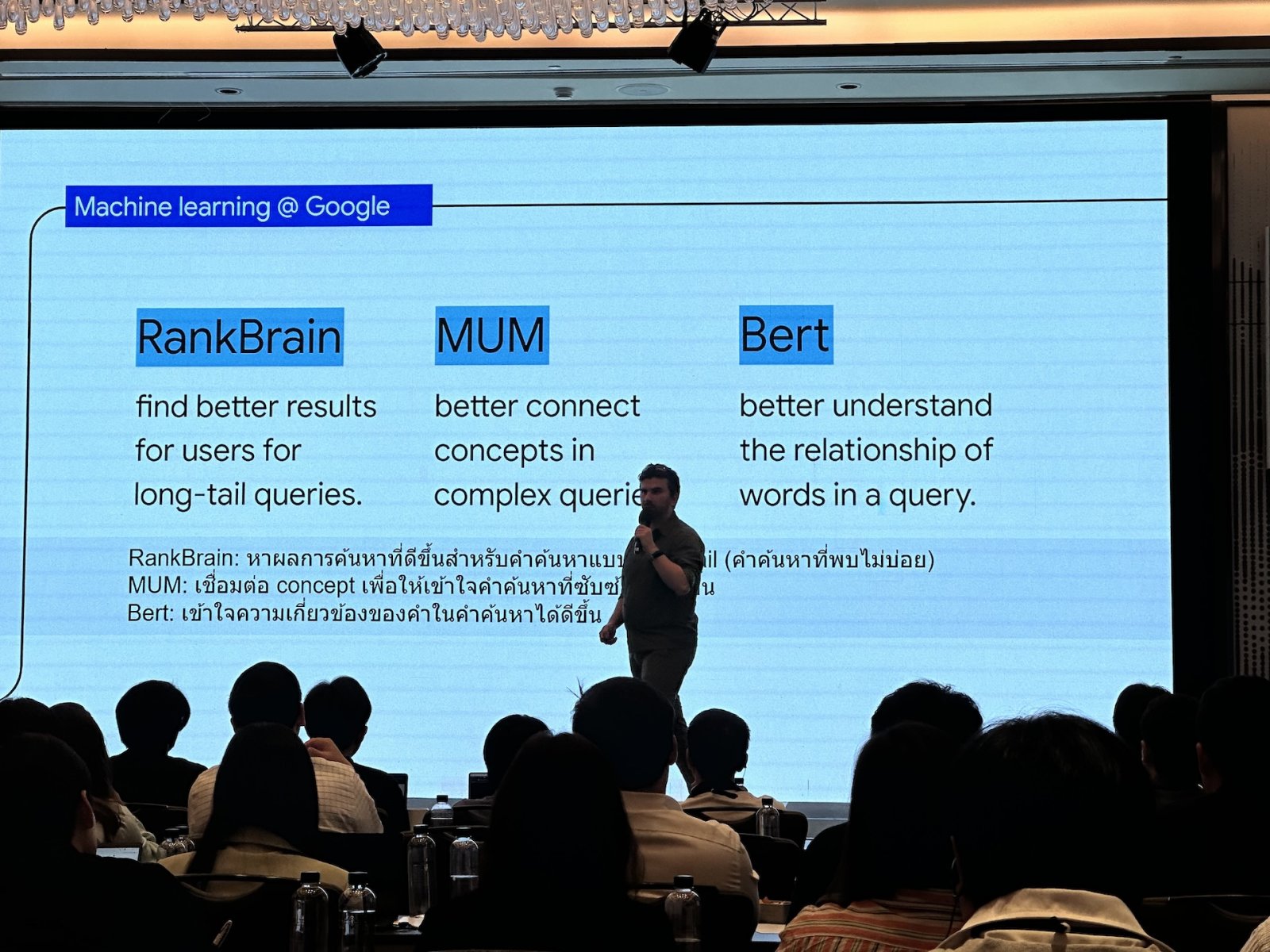

- ML อยู่ใต้ AI โดย ML คือระบบที่เรียนรู้จากข้อมูลจำนวนมาก

- LLM ก็อยู่ใต้ AI อีกที

- โดย Google ใช้ ML มานานกว่า 20 ปีแล้ว เช่น ใช้ตรวจสอบ spam และใช้ทำความเข้าใจเว็บและเนื้อหาต่าง ๆ

- LLM คืออัลกอริทึม AI แบบหนึ่ง ใช้เทคนิคการเรียนรู้เชิงลึกจากชุดข้อมูลขนาดใหญ่ เพื่อทำความเข้าใจ สรุป สร้าง และคาดการณ์เนื้อหาใหม่

- AI Overview ไม่ไช่ตัวเดียวกับ Gemini แต่ใช้ของตัวเองเลย โดยประมวลผลจากข้อมูลที่มีในเว็บ เลยไม่ค่อยมีปัญหาหลอน

- AI Overview ทำงานพวกสร้าง snippet สรุปข้อมูลในเว็บ ซึ่งก็สร้างคลิกได้มากขึ้นด้วย

- พูดถึง Gemini หน่อย ซึ่งมันอาจให้ข้อมูลผิดได้ เลยต้องใช้คนเข้ามาช่วยจูนข้อมูลที่ได้ แต่สุดท้ายก็ต้องเช็กข้อมูลที่ได้อีกที