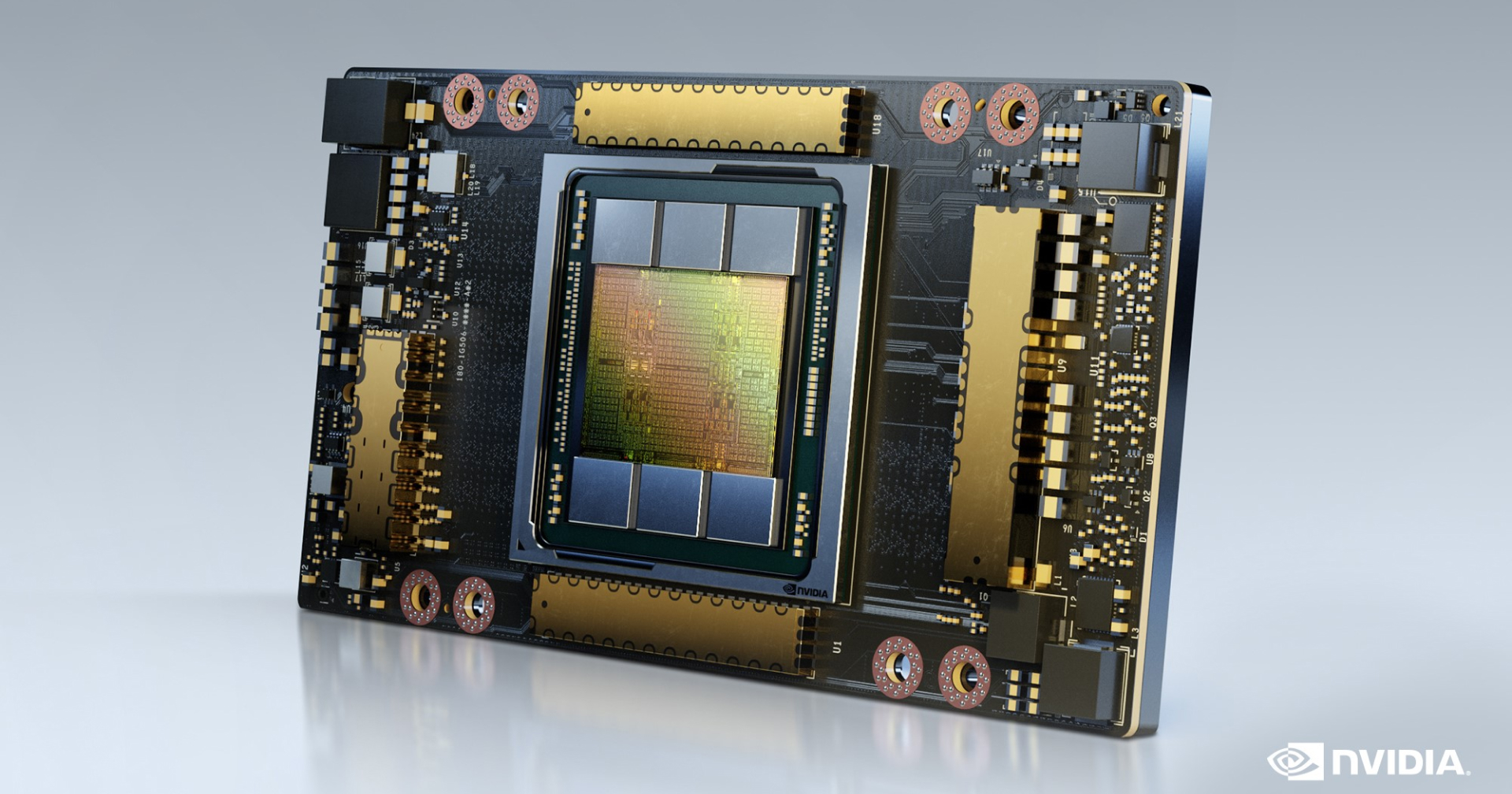

ยักษ์ใหญ่ทางเทคโนโลยีทั้ง Microsoft, Google และ Meta ต่างก็สร้าง AI ที่มีความเก่งกาจทางด้านข้อมูล แต่เครื่องมือที่สำคัญที่สุด และขาดหายไม่ได้คือขุมพลังขับเคลื่อน AI จากชิป GPU A100 ของ Nvidia ที่มีมูลค่ามากถึง 10,000 ดอลลาร์

ทางด้านนักลงทุน เนธาน เบนิช (Nathan Benaich) ได้เผยแพร่จดหมายข่าว และรายงานที่เกี่ยวข้องกับอุตสาหกรรม AI ที่รวมไปถึงบางส่วนที่เกี่ยวข้องกับซูเปอร์คอมพิวเตอร์ที่ใช้ชิป GPU A100 ว่า Nvidia ได้ครอบครองมากถึง 95% จีพียูสำหรับทำแมชชีนเลิร์นนิ่ง จากรายงานของ New Street Research

เริ่มแรก A100 ได้ถูกออกแบบมาเพื่อใช้งานเรนเดอร์กราฟิก 3 มิติที่ซับซ้อนภายในเกม แต่ในปัจจุบัน A100 จากทาง Nvidia ได้รับการกำหนดค่า และกำหนดเป้าหมายเพื่อการทำแมชชีนเลิร์นนิ่งในศูนย์ข้อมูล

A100 เหมาะกับโมเดลแมชชีนเลิร์นนิ่งอย่าง ChatGPT, Bing AI หรือ Stable Diffusion ที่สามารถทำการคำนวณแบบง่ายได้หลายอย่างพร้อม ๆ กัน ซึ่งเป็นสิ่งสำคัญที่สุดสำหรับการทำฝึกอบรม และการสร้างโมเดลโครงข่ายประสาทเทียม

การประมาณการจาก New Street Research ได้พบว่าโมเดล ChatGPT ของ OpenAI ที่ใช้สำหรับการค้นหาใน Bing อาจจะต้องใช้ชิป GPU A100 มากถึง 8 ตัวเพื่อการตอบสนอง และตอบคำถามที่ใช้เวลาน้อยกว่า 1 วินาที ในอัตราดังกล่าวนี้ Microsoft ต้องการเซิร์ฟเวอร์ 8-GPU มากกว่า 20,000 เครื่องสำหรับโมเดล Bing ซึ่งหมายถึง Microsoft อาจจะมีค่าใช้จ่ายพื้นฐานสำหรับเครื่องเซิร์ฟเวอร์ถึง 4,000 ล้านดอลลาร์

ทาง เจนเซ่น หวง (Jensen Huang) ซีอีโอ Nvidia ได้กล่าวการสัมภาษณ์กับ เคธี่ ทาราซอฟ (Katie Tarasov) จากสำนักข่าว CNBS ว่าผลิตภัณฑ์ของเรานั้นมีราคาไม่แพงสำหรับจำนวนการคำนวณที่โมเดลเหล่านี้ที่ต้องการ และ GPU จาก Nvidia จะมาช่วยให้สตาร์ทอัพสามารถฝึกฝนโมเดลด้วยต้นทุนที่ต่ำมากกว่าการใช้หน่วยประมวลผลคอมพิวเตอร์แบบเดิม ๆ

และในตอนนี้ AMD และ Intel ที่ต่างมี GPU ใช้สำหรับงานปัญญาประดิษฐ์ และบริษัทคลาวด์ขนาดใหญ่ทั้ง Google และ Amazon ก็กำลังพัฒนา และใช้งานชิปของตัวเองที่ได้รับการออกแบบที่พิเศษสำหรับงานเวิร์กโหลด AI โดยเฉพาะ

การแข่งขันที่ดุเดือดที่ชิป A100 จากทาง Nvidia ที่ได้ครองส่วนแบบการตลาดถึงมากที่สุดในตอนนี้ แต่ชิปตัวนี้ก็ได้เปิดตัวตั้งแต่ปี 2020 ซึ่งก็ถือว่าเป็นเวลาที่นานมากเช่นกัน และแล้วชิปจีพียูตัวใหม่ล่าสุดอย่าง H100 ที่ได้เปิดตัวในปี 2022 ก็กำลังอยู่ในขั้นตอนการผลิตในปริมาณที่มาก และจากบันทึกรายได้ชิป H100 ในไตรมาสที่สิ้นสุดในเดือนมกราคมมากกว่า A100 ตัวเก่า ถึงแม้ว่าราคาของชิป H100 จะแพงกว่าต่อหน่วยก็ตาม

Nvidia ได้บอกว่าชิป H100 ตัวนี้เป็นชิป GPU ตัวแรกในดาต้าเซ็นเตอร์ที่ได้รับการปรับปรุงให้เหมาะสมกับหม้อแปลงไฟฟ้า และการฝึกอบรม AI จะเร็วขึ้นกว่า 1 ล้านเปอร์เซ็นต์ นั่นก็หมายความว่าบริษัท AI ต่าง ๆ ก็ไม่จำเป็นที่จะต้องสั่งชิป Nvidia เป็นจำนวนมากอีกต่อไป

ที่มา CNBC

พิสูจน์อักษร : สุชยา เกษจำรัส