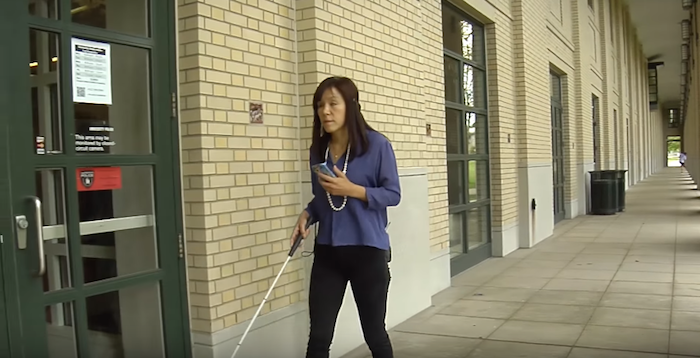

แอปพลิเคชั่น NavCog (เนฟค็อก) เกิดจากการร่วมมือกันระหว่าง สถาบัน IBM (ไอบีเอ็ม) และ ศูนย์วิจัยคาร์เนกี้ เมลลอน มันสามารถดึงข้อมูลจากเซ็นเซอร์ต่างๆ รวมถึงใช้ประโยชน์จากเทคโนโลยีค็อกนิทิฟ เพื่อแจ้งให้ผู้พิการทางสายตารับรู้ถึงสิ่งที่อยู่รอบตัวได้ ผ่านทางเสียงกระซิบที่หูฟังหรือการสั่นที่สมาร์ทโฟน โดยแอปดังกล่าวยังวิเคราะห์สัญญาณจากเซ็นเซอร์ของสมาร์ทโฟนและอุปกรณ์บลูทูธที่ติดตั้งอยู่ตามทางเดิน ช่วยให้ผู้ใช้สามารถเดินทางไปที่ต่างๆ ทั้งภายในและภายนอกอาคารได้โดยไม่ต้องมีคนคอยช่วยเหลือ ปัจจุบันได้เริ่มมีการเปิดให้ดาวน์โหลดแอพเนฟค็อกที่แอพสโตร์ได้โดยไม่เสียค่าใช้จ่ายแล้ว

นอกจากนี้ ยังมีการเปิดกว้างให้นักพัฒนาสามารถเข้าไปใช้ประโยชน์จากโค้ดและเครื่องมือพัฒนาแอปค็อกนิทิฟดังกล่าวได้ ผ่านทางคลาวด์บลูมิกซ์ของไอบีเอ็มด้วย โดยมีเครื่องมือต่างๆ เช่น เครื่องมือช่วยสร้างแอปสำหรับนำทาง เครื่องมือปรับแก้แผนที่ อัลกอริธึ่มสำหรับการปรับองค์ประกอบต่างๆ ให้ตรงกับตำแหน่งสถานที่นั้นๆ เป็นต้น ซึ่งจะช่วยให้ผู้พิการทางสายตาสามารถรู้ได้แทบจะทันทีว่าตนอยู่ที่ไหน กำลังหันหน้าไปทางไหน พร้อมทราบข้อมูลเกี่ยวกับสิ่งต่างๆ ที่อยู่รอบตัวในขณะนั้น โดยเครื่องมือสร้างแอพนำทางยังสามารถแปลงภาพสิ่งรอบตัวจากสมาร์ทโฟน ให้เป็นโมเดลพื้นที่สามมิติ เพื่อช่วยให้ผู้พิการทางสายตาสามารถเข้าใจลักษณะพื้นที่ที่ตนอยู่และช่วยให้การนำทางเป็นไปอย่างมีประสิทธิภาพยิ่งขึ้น

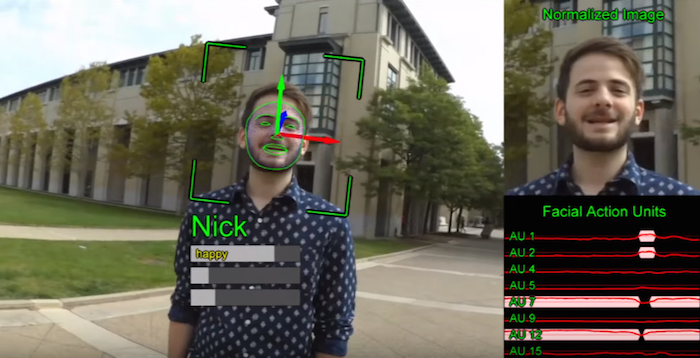

ปัจจุบันทีมนักวิจัยกำลังพยายามหาแนวทางเพื่อเพิ่มขีดความสามารถให้แอปรุ่นต่อๆ ไป เช่นการพัฒนาความสามารถในการรับรู้ว่าใครกำลังเข้ามาใกล้และบุคคลนั้นมีสภาวะทางอารมณ์เป็นอย่างไร รวมถึงการพัฒนาเทคโนโลยีช่วยผนวกข้อมูลจากเซ็นเซอร์หลากหลายรูปแบบรอบตัว เพื่อเพิ่มฟังก์ชั่นค็อกนิทิฟต่างๆด้วย เช่น การจำใบหน้าในสถานที่สาธารณะ การนำเทคโนโลยีอัลตร้าโซนิคมาช่วยให้การระบุสถานที่เป็นไปได้อย่างแม่นยำขึ้น เป็นต้น

แม้ตอนนี้จะยังเป็นเครื่องต้นแบบอยู่ แต่เชื่อว่าความพยายามในการพัฒนา และการเปิดโค้ดและเครื่องมือพัฒนา จะช่วยให้นักพัฒนาที่สนใจจากทั่วโลก ช่วยกันสร้างเครื่องช่วยนำทางให้กับผู้พิการทางสายตาได้สำเร็จในอนาคต และเราหวังว่ามันจะสำเร็จได้โดยดีน้า เป็นกำลังใจให้จ้า

ที่มา : hulop